Блискавичний старт — без складнощів

Основне: інсталяція в один клік, локальний інфраструктурний запуск, збереження приватності та мінімізація витрат: ніякого інтернет-з'єднання — дані залишаються у вас.

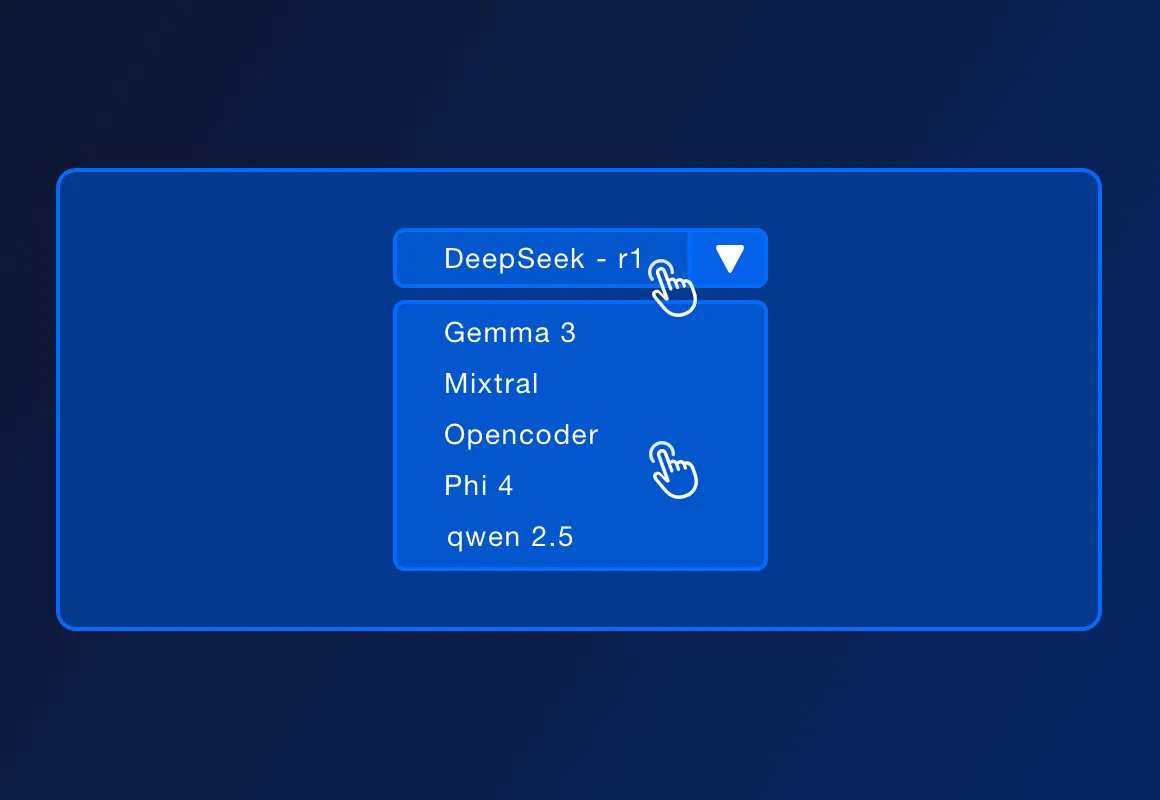

DeepSeek-r1, Llama 3.3, Mistral, Code Llama та інші — перелік розширюється з оновленнями.

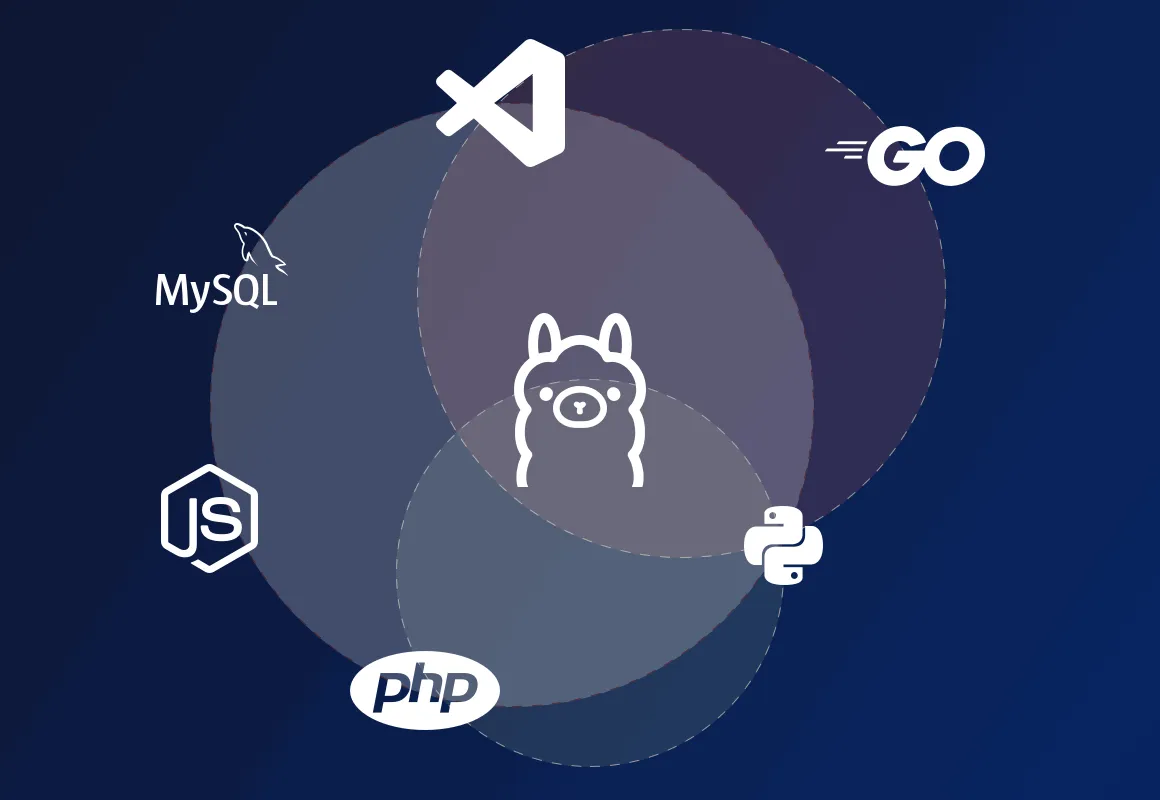

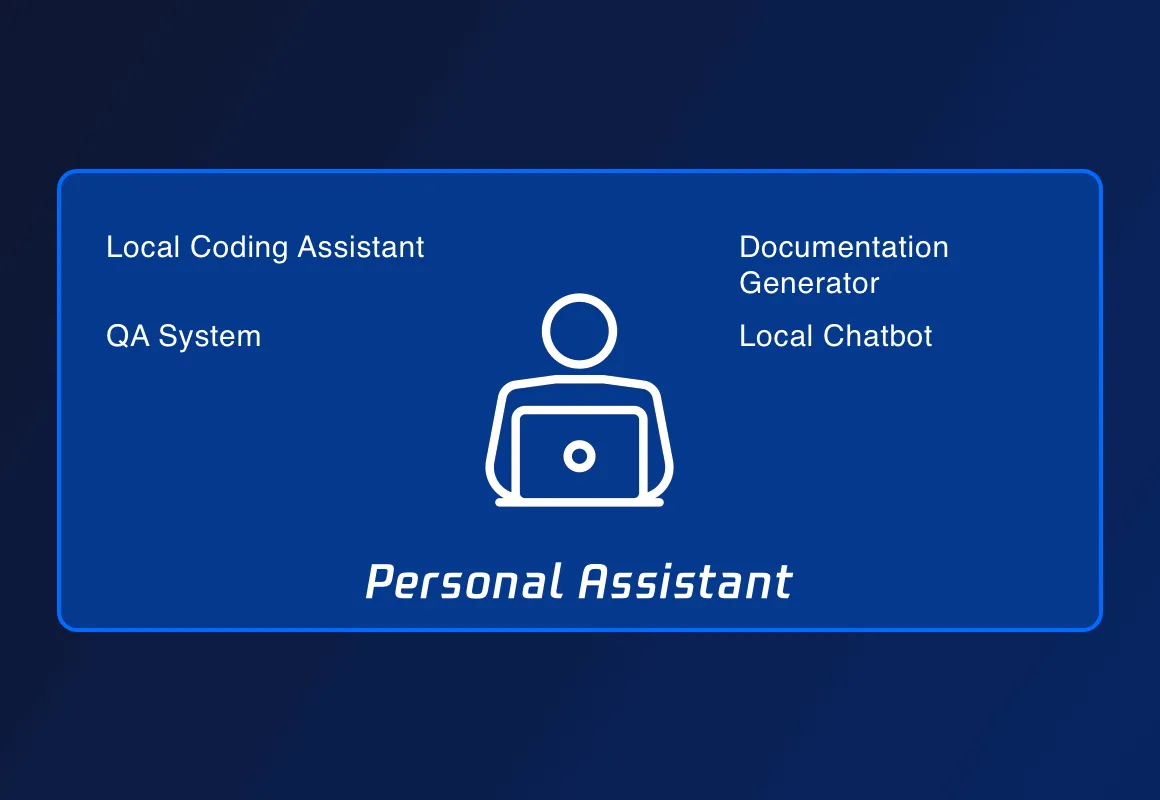

Так, ServBay дозволяє розгортати PHP, Python, Node.js, Go і Ollama локально. Цього достатньо для розробки, прототипування чи навчання, а у разі комерційного запуску запропоновані професійні рішення.

ServBay — це універсальна екосистема для керування всім стеком: мовами, БД, серверами, а тепер і AI-моделями. Робіть REST-запити до Ollama, керуйте застосунками локально без обмежень.